این مقاله انگلیسی ISI در نشریه اسپرینگر در 9 صفحه در سال 2018 منتشر شده و ترجمه آن 11 صفحه میباشد. کیفیت ترجمه این مقاله ویژه – طلایی ⭐️⭐️⭐️ بوده و به صورت کامل ترجمه شده است.

| دانلود رایگان مقاله انگلیسی + خرید ترجمه فارسی | |

| عنوان فارسی مقاله: |

ویژگی های توجه عمیق برای جداسازی پروستات در سونوگرافی |

| عنوان انگلیسی مقاله: |

Deep Attentional Features for Prostate Segmentation in Ultrasound |

|

|

|

| مشخصات مقاله انگلیسی | |

| فرمت مقاله انگلیسی | pdf و ورد تایپ شده با قابلیت ویرایش |

| سال انتشار | 2018 |

| تعداد صفحات مقاله انگلیسی | 9 صفحه با فرمت pdf |

| نوع مقاله | ISI |

| نوع نگارش | Conference paper |

| نوع ارائه مقاله | کنفرانس |

| رشته های مرتبط با این مقاله | پزشکی، مهندسی پزشکی |

| گرایش های مرتبط با این مقاله | ایمنی شناسی پزشکی، خون و آنکولوژی ؛ پردازش تصاویر پزشکی |

| چاپ شده در مجله (ژورنال) | کنفرانس بین المللی محاسبات تصویر پزشکی و مداخله به کمک رایانه – International Conference on Medical Image Computing and Computer-Assisted Intervention |

| ارائه شده از دانشگاه | آزمایشگاه ملی مهندسی فناوری ملی برای سونوگرافی پزشکی، دانشکده مهندسی پزشکی، مرکز علوم بهداشتی، دانشگاه شنژن، چین |

| نویسندگان | Yi Wang – Zijun Deng – Xiaowei Hu |

| شناسه دیجیتال – doi | https://doi.org/10.1007/978-3-030-00937-3_60 |

| بیس | نیست ☓ |

| مدل مفهومی | ندارد ☓ |

| پرسشنامه | ندارد ☓ |

| متغیر | ندارد ☓ |

| رفرنس | دارای رفرنس در داخل متن و انتهای مقاله ✓ |

| کد محصول | 11586 |

| لینک مقاله در سایت مرجع | لینک این مقاله در سایت Springer |

| نشریه | اسپرینگر – Springer |

| مشخصات و وضعیت ترجمه فارسی این مقاله | |

| فرمت ترجمه مقاله | pdf و ورد تایپ شده با قابلیت ویرایش |

| وضعیت ترجمه | انجام شده و آماده دانلود |

| کیفیت ترجمه | ویژه – طلایی ⭐️⭐️⭐️ |

| تعداد صفحات ترجمه تایپ شده با فرمت ورد با قابلیت ویرایش | 11 صفحه با فونت 14 B Nazanin |

| ترجمه عناوین تصاویر و جداول | ترجمه شده است ✓ |

| ترجمه متون داخل تصاویر | ترجمه شده است ✓ |

| ترجمه متون داخل جداول | ترجمه شده است ✓ |

| ترجمه ضمیمه | ندارد ☓ |

| ترجمه پاورقی | ندارد ☓ |

| درج تصاویر در فایل ترجمه | درج شده است ✓ |

| درج جداول در فایل ترجمه | درج شده است ✓ |

| درج فرمولها و محاسبات در فایل ترجمه | به صورت عکس درج شده است ✓ |

| منابع داخل متن | به صورت عدد درج شده است ✓ |

| منابع انتهای متن | به صورت انگلیسی درج شده است ✓ |

| فهرست مطالب |

|

چکیده 1- مقدمه 2- ویژگیهای توجه عمیق برای جداسازی 2-1 بررسی کلی روش 2-2 ویژگیهای توجه عمیق 3- آزمایشها 3-1 مواد 3-2 استراتژیهای آموزش دادن و آزمایش کردن 3-3 عملکرد جداسازی 4- نتیجهگیری |

| بخشی از ترجمه |

|

چکیده تقسیم خودکار پروستات در ﺳﻮﻧﻮﮔﺮاﻓﯽ ﺗﺮاﻧﺲ رﮐﺘﺎل (TRUS) برای بافتبرداری تصاویر هدایتشده پروستات و برنامهریزی درمان بسیار حائر اهمیت میباشد. همچنین بهدلیل مرز مبهم و توزیع شدت غیرهمگن پروستات در TRUS، توسعه دادن اینگونه راهحلهای خودکار هنوز چالشبرانگیز باقیمانده است. در این پژوهش، یک شبکهی عصبی عمیق جدید که با ماژولهای ویژگی توجه عمیق (DAF) مجهز شده است، برای جداسازی بهتر پروستات در TRUS با استفاده از استخراج کردن اطلاعات مکمل کدگذاریشده در لایههای مختلف شبکهی عصبی پیچشی (CNN) توسعه داده شده است. همچنین DAF متعلق به ما جهت انتخاب قدرت نفوذ ویژگیهای چندگانهی ادغامشده از طریق لایههای مختلف برای تصحیح کردن ویژگیهای هر لایهی منحصربهفرد، متوقف کردن سروصدای غیرپروستات در لایههای کمعمق CNN و افزایش دادن تعداد جزئیات پروستات درون ویژگیهای لایههای عمیق از مکانیزم توجه استفاده میکند. ما تأثیر شبکهی پیشنهادی را بر روی تصاویر چالشبرانگیز TRUS پروستات و همچنین نتایج تجربی ارزیابی میکنیم تا عملکرد بهتر روشهای نوین را بهوسیلهی یک تفاوت مزیت بزرگ نشان دهیم.

1- مقدمه سرطان پروستات بهعنوان رایجترین سرطان غیرپوستی شناخته میشود و دومین سرطان ایجادکنندهی مرگ در مردان میباشد ]9[. فراوادرمانی ترانسرکتال (TRUS) یک حالت تصویربرداری معمول برای بافتبرداری تصاویر هدایتشده و درمان سرطان پروستات میباشد. جداسازی پروستات از طریق TRUS برای برنامهریزی درمان بسیار حائز اهمیت میباشد ]10[ و میتواند به تثبیت مبتنی بر سطح بین TRUS و MRI قبل از عمل در هنگام مداخلات تصاویر هدایتشده کمک نماید ]11[. همچنین بهدلیل از بین رفتن یا مبهم بودن مرز و توزیع شدت غیرهمگن پروستات در TRUS و همچنین تغییرات شکلی بزرگ پروستاتهای مختلف، جداسازی دقیق پروستات در TRUS هنوز چالشبرانگیز باقیمانده است (شکل 1 مشاهده شود). |

| بخشی از مقاله انگلیسی |

|

Abstract Automatic prostate segmentation in transrectal ultrasound (TRUS) is of essential importance for image-guided prostate biopsy and treatment planning. However, developing such automatic solutions remains very challenging due to the ambiguous boundary and inhomogeneous intensity distribution of the prostate in TRUS. This paper develops a novel deep neural network equipped with deep attentional feature (DAF) modules for better prostate segmentation in TRUS by fully exploiting the complementary information encoded in different layers of the convolutional neural network (CNN). Our DAF utilizes the attention mechanism to selectively leverage the multi-level features integrated from different layers to refine the features at each individual layer, suppressing the non-prostate noise at shallow layers of the CNN and increasing more prostate details into features at deep layers. We evaluate the efficacy of the proposed network on challenging prostate TRUS images, and the experimental results demonstrate that our network outperforms state-of-the-art methods by a large margin.

1 Introduction Prostate cancer is the most common noncutaneous cancer and the second leading cause of cancer-related deaths in men [9]. Transrectal ultrasound (TRUS) is the routine imaging modality for image-guided biopsy and therapy of prostate cancer. Segmenting prostate from TRUS is of essential importance for the treatment planning [10], and can help surface-based registration between TRUS and preoperative MRI during image-guided interventions [11]. However, accurate prostate segmentation in TRUS remains very challenging due to the missing/ambiguous boundary and inhomogeneous intensity distribution of the prostate in TRUS, as well as the large shape variations of different prostates (see Fig. 1). |

|

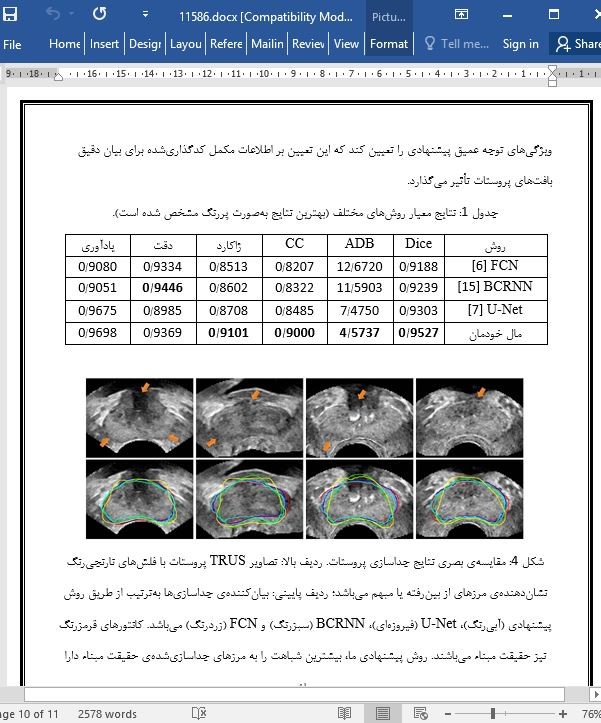

تصویری از مقاله ترجمه و تایپ شده در نرم افزار ورد |

|

|

| دانلود رایگان مقاله انگلیسی + خرید ترجمه فارسی | |

| عنوان فارسی مقاله: |

ویژگی های توجه عمیق برای جداسازی پروستات در سونوگرافی |

| عنوان انگلیسی مقاله: |

Deep Attentional Features for Prostate Segmentation in Ultrasound |

|

|

|