این مقاله انگلیسی ISI در نشریه ساینس دایرکت (الزویر) در 17 صفحه در سال 2017 منتشر شده و ترجمه آن 20 صفحه میباشد. کیفیت ترجمه این مقاله ویژه – طلایی ⭐️⭐️⭐️ بوده و به صورت کامل ترجمه شده است.

| دانلود رایگان مقاله انگلیسی + خرید ترجمه فارسی | |

| عنوان فارسی مقاله: |

یادگیری ساختاری در شبکه های عصبی مصنوعی با بهینه سازی پراکنده |

| عنوان انگلیسی مقاله: |

Structural learning in artificial neural networks using sparse optimization |

|

|

|

| مشخصات مقاله انگلیسی (PDF) | |

| سال انتشار | 2017 |

| تعداد صفحات مقاله انگلیسی | 17 صفحه با فرمت pdf |

| رشته های مرتبط با این مقاله | مهندسی صنایع و کامپیوتر |

| گرایش های مرتبط با این مقاله | بهینه سازی سیستم ها، مهندسی الگوریتم ها و محاسبات |

| مجله | محاسبات عصبی – Neurocomputing |

| دانشگاه | طراحی فرایند و مهندسی سیستم، دانشکده علوم و مهندسی، دانشگاه Åbo Akademi، فنلاند |

| کلمات کلیدی | شبکه های عصبی مصنوعی، یادگیری ساختاری، بهینه سازی تنک، وزن دهی مجدد تکراری |

| رفرنس | دارد ✓ |

| کد محصول | 357 |

| لینک مقاله در سایت مرجع | لینک این مقاله در نشریه Elsevier |

| شناسه دیجیتال – doi | https://doi.org/10.1016/j.neucom.2017.07.028 |

| نشریه الزویر |  |

| مشخصات و وضعیت ترجمه فارسی این مقاله (Word) | |

| وضعیت ترجمه | انجام شده و آماده دانلود |

| کیفیت ترجمه | ویژه – طلایی ⭐️⭐️⭐️ |

| تعداد صفحات ترجمه تایپ شده با فرمت ورد با قابلیت ویرایش | 20 صفحه با فونت 14 B Nazanin |

| ترجمه عناوین تصاویر و جداول | ترجمه شده است ✓ |

| ترجمه متون داخل تصاویر | ترجمه شده است ✓ |

| ترجمه متون داخل جداول | ترجمه شده است ✓ |

| درج تصاویر در فایل ترجمه | درج شده است ✓ |

| درج جداول در فایل ترجمه | درج شده است ✓ |

| درج فرمولها و محاسبات در فایل ترجمه به صورت عکس | درج شده است ✓ |

| منابع داخل متن | به صورت عدد درج شده است ✓ |

| فهرست مطالب |

|

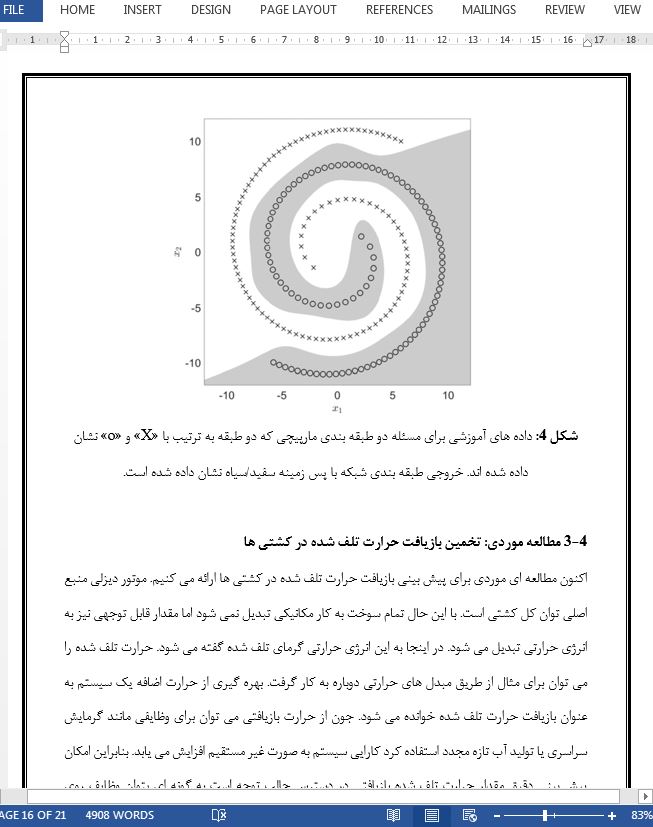

نکات برجسته چکیده 1 مقدمه 2 ساختار شبکه و نشان گذاری 3 همبندی تنک در شبکه های عصبی 3-1 بهینه سازی تنک 3-2 راه حل های تقریبی (P*0) 3-3 جستجوی خط پس گرد 4 آزمایش ها 4-1 مثال تشریحی 4-2 مثال تشریحی: طبقه بندی 4-3 مطالعه موردی: تخمین بازیافت حرارت تلف شده در کشتی ها 5 نتیجه گیری اظهارات |

| بخشی از ترجمه |

|

چکیده در این مقاله مسئله تخمین همزمان ساختار و پارامترهای شبکه های عصبی مصنوعی با چندین لایه مخفی در نظر گرفته می شود. روشی بر مبنای بهینه سازی تنک ارائه می شود. مسئله به صورت یک مسئله کمینه سازی هنجار ℓ0 به گونه ای فرمول بندی می شود که اوزان افزونه از شبکه عصبی حذف می شوند. چنین مسائلی به طور کلی ترکیبی هستند و اغلب حل نشدنی در نظر گرفته می شوند. بنابراین یک وزن دهی مجدد سلسله مراتبی تکراری برای آسان سازی هنجار ℓ0 ارائه می شود. آزمایش هایی روی مسائل محک ساده، برای طبقه بندی و رگرسیون و روی یک مطالعه موردی برای تخمین حرارت تلف شده در کشتی ها، انجام گرفته است. تمامی آزمایش ها بیانگر کارآمدی الگوریتم هستند.

5- نتیجه گیری اظهارات در این مقاله یک تکنیک بهینه سازی تنک مبتنی بر وزن دهی مجدد تکراری را برای آموزش ساختاری در شبکه های عصبی مصنوعی ارائه کردیم. روش پیشنهادی به شکلی کلی ارائه شد، به گونه ای که به انواع مختلفی از گونه های شبکه، مانند مفاهیم جند لایه، شبکه های تابع پایه شعاعی یا ماشین های آموزش مفرط اعمال می شود. نتایج آزمایشگاهی رگرسیون و همچنین طبقه بندی کارآیی الگوریتم را نشان می دهند. قیدهای ساختاری بیشتر، مانند تنکی گروهی، را می توان به سادگی از طریق لسو گروهی در چارچوب پیشنهادی ما گنجاند. برای شبکه های نوع RBF، که توابع مبنا محدب هستند، لایه مخفی را می توان به صورت یک هسته نیمه معین مثبت تفسیر کرد که شرایط مرسر را برآورده می کند. این امر یافتن راه حل های صریح برای هر مرحله تکرار را ممکن می سازد که الگوریتم پیشنهادی را از نظر محاسباتی کارآمد می سازد. در این حالت مسئله پیشنهادی برای فرمول بندی تشابه بسیاری را با ماشین های بردار پشتیبان حراقل مربعات نشان می دهد، اما رویه وزن دهی مجدد تکراری ارائه شده ارتقای تنکی را در این مدل امکان پذیر می کند. |

| بخشی از مقاله انگلیسی |

|

Abstract In this paper, the problem of simultaneously estimating the structure and parameters of artificial neural networks with multiple hidden layers is considered. A method based on sparse optimization is proposed. The problem is formulated as an `0-norm minimization problem, so that redundant weights are eliminated from the neural network. Such problems are in general combinatorial, and are often considered intractable. Hence, an iterative reweighting heuristic for relaxing the `0-norm is presented. Experiments have been carried out on simple benchmark problems, both for classification and regression, and on a case study for estimation of waste heat recovery in ships. All experiments demonstrate the effectiveness of the algorithm.

5. Concluding remarks In this paper we proposed a sparse optimization technique, based on iterative reweighing for structural learning in artificial neural networks. The proposed method was presented in a general form so that it applies to various types of network types, such as multi-layer perceptions, radial-basis-function networks or extreme learning machines. Experimental results for both regression as well as classification demonstrate the effectiveness of the algorithm. Model complexity was significantly reduced in all cases, and sparse network structures were obtained. Additional structural constraints, such as group sparsity, can easily be included in our proposed framework via group Lasso. For RBF-type networks, where the basis functions are convex, the hidden layer can be interpreted as an positivesemi-definite kernel, which satisfies Mercer’s conditions. This makes it possible to find explicit solutions for each iteration step, which makes the proposed algorithm computationally efficient. In this case, the proposed problem formulation shows strong similarities to the least-squares support-vector-machines, but the presented iterative reweighting procedure makes it possible to promote sparsity in the model.

|

|

تصویری از مقاله ترجمه و تایپ شده در نرم افزار ورد |

|

|

| دانلود رایگان مقاله انگلیسی + خرید ترجمه فارسی

|

|

| عنوان فارسی مقاله: |

یادگیری ساختاری در شبکه های عصبی مصنوعی با بهینه سازی پراکنده |

| عنوان انگلیسی مقاله: |

Structural learning in artificial neural networks using sparse optimization |

|

|

|